موظف OpenAI يكتشف تأثير Eliza، فيصبح عاطفيًا

إن تصميم برنامج بطريقة تمكنه من إقناع شخص ما بوجود إنسان آخر على الجانب الآخر من الشاشة كان هدفًا لمطوري الذكاء الاصطناعي منذ أن اتخذ المفهوم خطواته الأولى نحو الواقع. أعلنت شركة الأبحاث OpenAI مؤخرًا عن منتجها الرئيسي سيحصل ChatGPT على عيون وآذان وصوت في سعيها للظهور أكثر إنسانية. الآن، تقول مهندسة سلامة الذكاء الاصطناعي في OpenAI إنها أصبحت “عاطفية للغاية” بعد استخدام الوضع الصوتي لبرنامج الدردشة الآلية للحصول على جلسة علاج مرتجلة.

قال ليليان ونج، رئيس أنظمة السلامة في OpenAI، في تغريدة: “لقد أجريت للتو محادثة شخصية وعاطفية للغاية مع ChatGPT في الوضع الصوتي، وتحدثنا عن التوتر والتوازن بين العمل والحياة”. نشر أمس. “من المثير للاهتمام أنني شعرت بالدفء والسمع. لم تجرب العلاج من قبل ولكن ربما هذا هو الحال؟ جربه خاصة إذا كنت تستخدمه عادةً كأداة إنتاجية.

من الواضح أن تجربة Weng كموظف في OpenAI يروج لفوائد منتج OpenAI يجب أن تؤخذ بقدر كبير من الحماسة، لكنها تتحدث عن أحدث محاولات Silicon Valley لإجبار الذكاء الاصطناعي على الانتشار في كل زاوية وركن من حياتنا العامة. كما أنه يتحدث أيضًا عن أجواء كل شيء قديم جديد مرة أخرى في هذه اللحظة في ظهور الذكاء الاصطناعي.

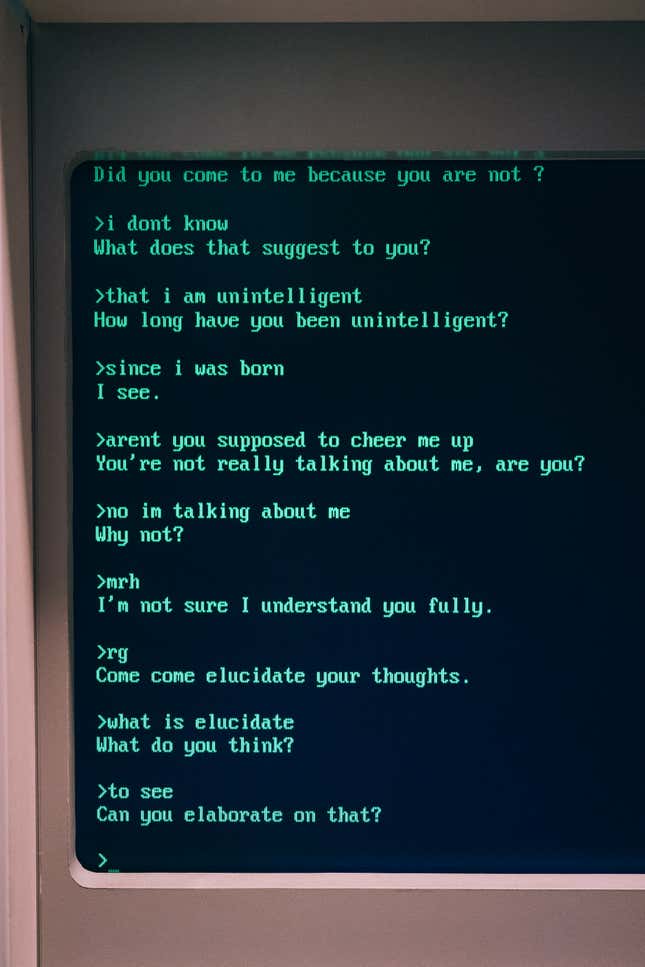

أدى التفاؤل التكنولوجي في الستينيات إلى ظهور بعض التجارب المبكرة مع “الذكاء الاصطناعي”، والتي تجلت في محاكاة عمليات التفكير البشري باستخدام الكمبيوتر. إحدى تلك الأفكار كانت عبارة عن برنامج حاسوبي لمعالجة اللغات الطبيعية يُعرف باسم إليزاتم تطويره بواسطة جوزيف وايزنباوم من معهد ماساتشوستس للتكنولوجيا.

قامت إليزا بتشغيل نص يسمى دكتور والذي تم تصميمه على أنه ملف محاكاة ساخرة للطبيب النفسي كارل روجرز. بدلاً من الشعور بالوصم والجلوس في مكتب طبيب نفسي خانق، يمكن للأشخاص بدلاً من ذلك الجلوس على محطة كمبيوتر خانقة بنفس القدر للحصول على المساعدة في أعمق مشكلاتهم. باستثناء أن إليزا لم تكن ذكية إلى هذا الحد، وكان النص يلتصق ببساطة بكلمات رئيسية وعبارات معينة ويعكسها بشكل أساسي للمستخدم بطريقة مبسطة بشكل لا يصدق، تمامًا كما يفعل كارل روجرز. وفي تطور غريب، بدأ وايزنباوم في ملاحظة أن مستخدمي إليزا أصبحوا مرتبطين عاطفيًا بمخرجات البرنامج البدائية – يمكنك القول إنهم شعروا بأنهم “مسموعون ودافئون” لاستخدام كلمات ونغ الخاصة.

كتب وايزنباوم لاحقًا في كتابه الذي صدر عام 1976: “ما لم أدركه هو أن التعرض لفترة قصيرة جدًا لبرنامج كمبيوتر بسيط نسبيًا يمكن أن يحفز التفكير الوهمي القوي لدى الأشخاص العاديين”. قوة الكمبيوتر والعقل البشري.

إن القول بأن الاختبارات الأحدث في علاج الذكاء الاصطناعي قد انهارت واحترقت أيضًا سيكون بمثابة الاستخفاف بالأمر. تطبيق الصحة العقلية من نظير إلى نظير قررت كوكو تجربة الذكاء الاصطناعي الذي يتظاهر بأنه مستشار لـ 4000 من مستخدمي المنصة. صرح روب موريس، المؤسس المشارك للشركة، لموقع Gizmodo في وقت سابق من هذا العام أن “هذا سيكون المستقبل”. يمكن للمستخدمين الذين يقومون بدور المستشارين إنشاء ردود باستخدام Koko Bot – وهو تطبيق ChatGPT3 الخاص بـ OpenAI – والتي يمكن بعد ذلك تحريرها أو إرسالها أو رفضها تمامًا. وبحسب ما ورد تم إنشاء 30 ألف رسالة باستخدام الأداة التي تلقت ردودًا إيجابية، لكن Koko سحبت القابس لأن برنامج الدردشة الآلي شعر بالعقم. عندما شارك موريس تجربته على تويتر (المعروف الآن باسم X)، كان رد الفعل العام لا يمكن التغلب عليه.

على الجانب المظلم من الأمور، في وقت سابق من هذا العام، رجل بلجيكي قالت الأرملة زوجها مات منتحرًا بعد أن انخرط في محادثات مع الذكاء الاصطناعي مما شجعه على قتل نفسه.

في شهر مايو الماضي، اتخذت الجمعية الوطنية لاضطرابات الأكل خطوة جريئة بحل الخط الساخن الخاص باضطرابات الأكل، والذي يمكن لمن يعانون من أزمة الاتصال به طلبًا للمساعدة. في مكانها، اختارت NEDA استبدال موظفي الخط الساخن ببرنامج chatbot اسمه تيسا. حدث الفصل الجماعي بعد أربعة أيام فقط من انضمام الموظفين إلى النقابات، وقبل ذلك، شعر الموظفون بنقص الموارد والإرهاق في العمل، وهو أمر مزعج بشكل خاص عند العمل بشكل وثيق مع السكان المعرضين للخطر. وبعد أقل من أسبوع من استخدام تيسا، نيدا اغلاقأعد روبوت الدردشة. وفقا ل بريد على صفحة Instagram الخاصة بالمنظمة غير الربحية، ربما تكون تيسا قد قدمت معلومات ضارة ولا علاقة لها بالبرنامج.

باختصار، إذا لم يسبق لك أن خضعت للعلاج وتفكر في تجربة برنامج الدردشة الآلي كبديل، فلا تفعل ذلك.